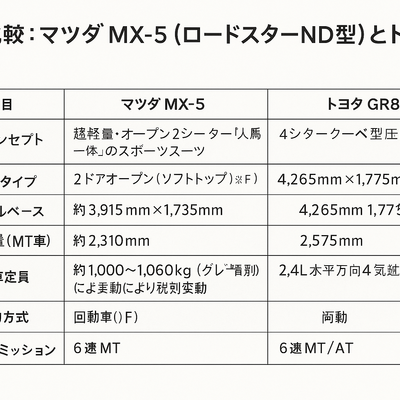

設計原則とワークロード特性の明確化

生成AIのクラウド設計は、LLM推論とベクトルDBのデータ局所性、スループット変動、厳格なセキュリティ境界を同時に満たすアーキテクチャが要件となる。レイテンシはトークン初回応答(TTFT)とトークン間隔(TPOT)で分解し、RAGの上流(埋め込み生成・検索)と下流(合成・ポストプロセス)で別々にSLOを設定する。基本原則は、(1)同一リージョンかつ同一AZでの推論サービングとベクトル検索の同居、(2)ホットパスのネットワーク往復の最小化、(3)GPU効率の最大化とキャッシュ率向上、(4)ゼロトラスト前提のデータ保護である。

LLM推論の低レイテンシ化とサービング基盤

TTFT短縮にはモデルの量子化(INT4/INT8、AWQ/GPTQ)と重みロード最適化、KVキャッシュの活用が効く。vLLMやPagedAttentionでKVスワップを抑制し、TensorRT-LLMやFlashAttention 2でカーネル最適化を行う。バッチングは遅延を生まない範囲で動的バッチャを用い、SLOに応じた二層構成(低遅延小バッチ用フロントプールと高効率大バッチ用バックプール)を採用する。スペキュレーティブデコーディングやハイブリッドデコーダ(小型モデルで先読み、大型で検証)はTPOTを下げ、ストリーミング出力はユーザー体感を改善する。GPUはMIGで分割しスモールワークロードの無駄を抑え、MPSで同時実行度を上げる。モデルサイズは単一GPU常駐を第一目標とし、不可ならテンソル並列を最小段数で構成する。ホットスタートのためにウォームプールを維持し、スケールアウト時はリーダーレプリカを先行昇格する。

ベクトルDBの選定とインデックス戦略

レイテンシ最適化ではHNSWとIVF-PQのトレードオフを評価する。高リコール・低遅延が必要なQAではHNSW(MとefSearchを動的調整)、大規模データのコスト最適化にはIVF-PQやOPQで圧縮率を高める。GPUアクセラレーション(cuVS、RAFT、FAISS-GPU)でインデックス構築とクエリを短縮し、ホットセットはGPUメモリ、ウォームセットはRAM、コールドセットはNVMeに階層化する。ハイブリッド検索(ベクトル+BM25)とメタデータフィルタで精度を上げ、近接計算は同一AZ内のプライベートエンドポイント経由に限定する。運用面ではインクリメンタル更新とバックグラウンド再クラスタリング、スナップショットの暗号化、スキーマ版管理を実装する。マネージド(Pinecone、Weaviate、Vertex/Bedrockの相当サービス)か自前(pgvector、Milvus、Elasticsearch+kNN)は運用責任範囲とデータ主権要件で決める。

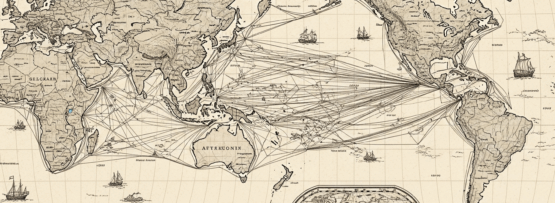

RAGパイプラインのネットワークとデータ局所性

埋め込み生成→索引→検索→合成のホットパスは同一VPC内で完結させ、VPC Peering/PrivateLinkを使いパブリック経由を排除する。gRPC/HTTP2の長寿命コネクション、TLS1.3、圧縮辞書の事前共有でオーバーヘッドを削減する。文書取り込みは非同期バルク、前処理(分割・正規化・PIIマスキング)はストレージ隣接のサーバレスジョブで行い、eGPUを使わないCPUバッチでコストを抑制する。キャッシュは三層で設計する。(1)プロンプト正規化+応答キャッシュ(キーはテンプレ+検索ヒットID)、(2)埋め込みキャッシュ(テキスト正規化ハッシュ)、(3)KVキャッシュのプレフィックス共有。キャッシュ無効化はデータの版IDで厳密に管理し、RAGのK値はレイテンシ予算内で動的調整する。

セキュリティとガバナンス

データは保存時・転送時の暗号化に加え、メモリ暗号化(AMD SEV-SNP、Intel TDX)や機密VMでモデル重みとプロンプトを保護する。IAMはワークロードIDベース、最小権限、短命トークンを原則とし、ベクトルDBにはテナント境界を強制するロールと行レベルフィルタを設定する。KMSによるエンベロープ暗号、顧客管理キー(CMK)、キー分離で外部委託リスクを低減する。ログはトークン化・部分マスキングを標準とし、学習・評価データへの二次利用はデータ契約と監査証跡で統制する。外部LLM APIを併用する場合はプライベート接続とデータ保持オプトアウトを必須化する。

コスト最適化とユニットエコノミクス

コストは「1トークン当たりの総コスト」で把握し、GPU時間、ストレージ、ネットワーク、ベクトルクエリを含めて計測する。スポット/プリエンプティブルGPUを活用し、チェックポイント再開とウォームスタートで停止耐性を確保する。量子化で単一GPU常駐を実現すれば横展開のスケール効率が大幅に向上する。需要スパイクはキューの待ち時間SLOを上限にバックプレッシャを掛け、低優先度は遅延許容プールへ退避させる。出庫課金はリージョン内完結、同一クラウド接続、CDN・エッジキャッシュで最小化する。ストレージは原本をオブジェクト、インデックスはNVMe、スナップショットは低頻度層に分離し、ライフサイクルで自動遷移する。

運用監視とSLO駆動の最適化

可観測性はリクエストIDでRAG全段を分散トレースし、TTFT/TPOT/TBT、GPU利用率、メモリ帯域、KV命中率、インデックス再構築時間、検索のRecall@kとnDCGを常時可視化する。品質はガードレール違反率、ハルシネーション指標、ソース帰属率、コンテキスト長別の劣化を自動評価し、プロンプトと検索パラメータをオンラインで多腕バンディット最適化する。デプロイはカナリアとシャドーで安全性を担保し、SLO違反時はモデルロールバック、K値縮小、生成長制限を自動発火させる。

マルチテナンシー、レジデンシー、レギュレーション対応

テナント隔離はネットワーク(専用サブネット)、計算(MIG分割+cgroup)、データ(暗号鍵分離)で多層に実装する。データレジデンシーは地域別にRAGスタックを完結させ、メタデータ同期は匿名化・最小化を原則とする。規制要件(医療・金融)は監査可能な構成管理、SBOM、再現可能なビルド、モデル版固定、プロンプト・応答の保持期限と削除APIを提供し、外部委託先のサブプロセッサも可視化する。オンプレやSaaSを跨ぐ場合は同等の暗号・監査基準を適用し、ゼロ知識証明や機密計算の選択肢を評価する。